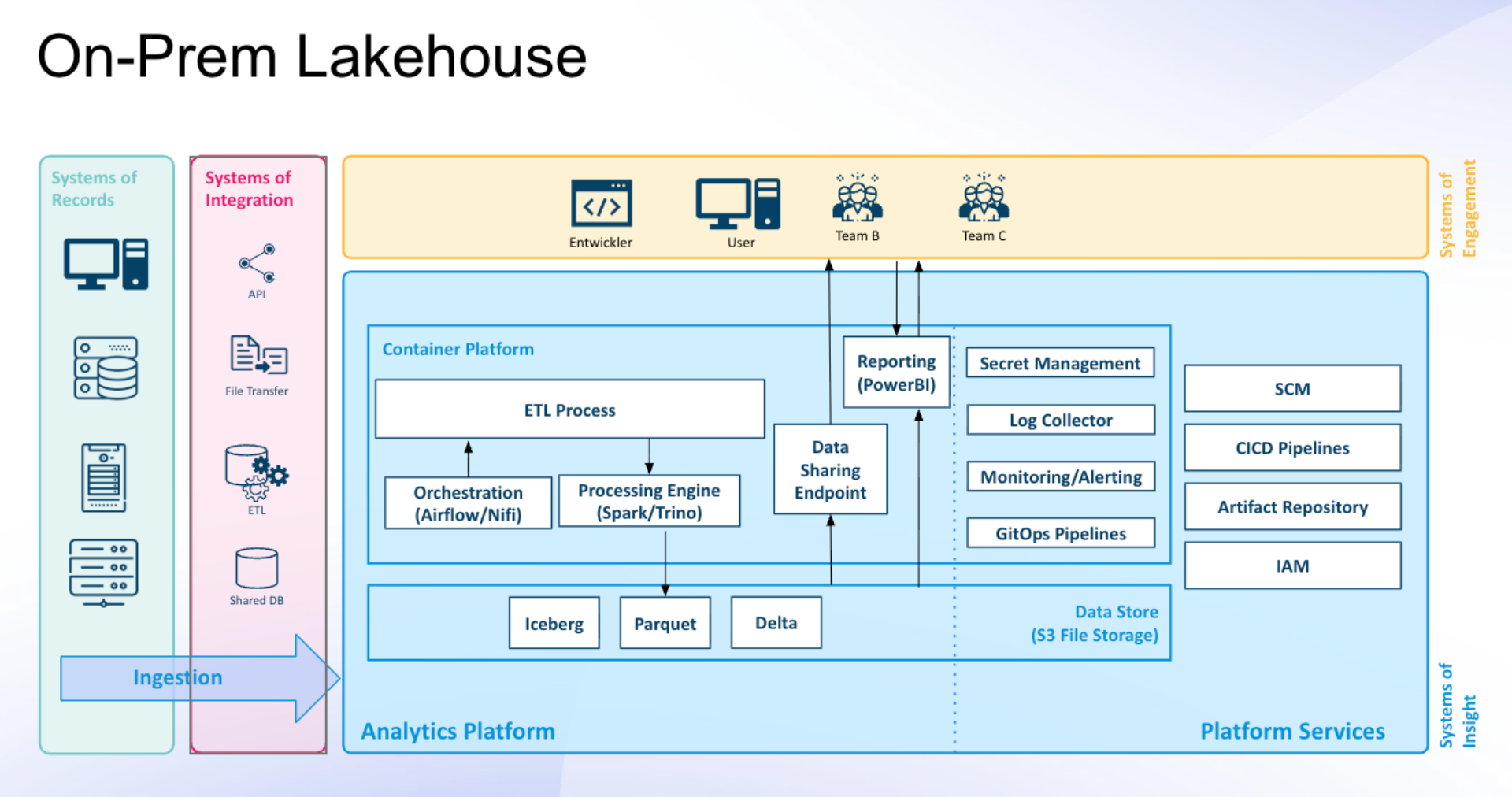

Dateneingang: Wie kommen die Daten ins Lakehouse

Die Systems of Records, also die Quellsysteme, bilden die Ursprungsorte der Daten. Dazu zählen beispielsweise Kundendatenbanken, interne Geschäftsanwendungen oder auch externe Partner-Systeme.

Auf diese Quellsysteme aufbauend kommen die Systems of Integration, die Integrationssysteme, zum Einsatz. Sie sind dafür verantwortlich, die Daten sicher zu transportieren. Dabei kommen unterschiedliche Technologien zum Einsatz, wie Schnittstellen über APIs, Dateiübertragungen oder ETL-Prozesse (Extrahieren, Transformieren, Laden), die sicherstellen, dass die Rohdaten zuverlässig aus den Quellsystemen übertragen werden.

Analytics Platform: Das Herzstück der Datenverarbeitung im Lakehouse

Die Fundamente (Data Store)

- Basis: Der Data Store (Speicher), oft realisiert als S3 File Storage (kostengünstiger Objektspeicher).

- Dateiformate (Parquet, Delta, Iceberg): Daten werden nicht nur als lose Dateien gespeichert, sondern in speziellen Formaten wie Parquet und mit einer zusätzlichen intelligenten Schicht (z. B. Delta oder Iceberg). Diese bietet Funktionen, die man sonst nur aus Datenbanken kennt:

- Reliability: Stellt sicher, dass Daten nur vollständig oder gar nicht gespeichert werden (ACID-Prinzip).

- Struktur: Ermöglicht nachträglich eine klare Struktur (Schema) der Daten.

- Time Travel (Historisierung): Ermöglicht den Zugriff auf ältere Versionen der Daten.

Die Daten-Fabrik (ETL Process)

- Container-Plattform: Häufig auf Kubernetes basierend, stellt sie die technische Umgebung für die Datenverarbeitungsprozesse bereit.

Entwicklung: Prozesse werden typischerweise mit Programmiersprachen wie Python erstellt und orchestriert.

Kernkomponenten

- Orchestration (Airflow/NiFi): Der Dirigent des Datenflusses. Plant und steuert komplexe Verarbeitungsschritte, sodass alles in der richtigen Reihenfolge und zum richtigen Zeitpunkt abläuft.

- Processing Engine (Spark/Trino): Der Hochleistungsrechner für Datenbereinigung, Anreicherung und Umstrukturierung (ETL). Er verwandelt rohe, unstrukturierte Daten in wertvolle, analysefertige Informationen.

Platform Services: Die Hilfsmittel für einen reibungslosen Betrieb des Lakehouses

Ein zentrales Element der Plattform ist ein durchgängiges Secret Management, das Passwörter, Tokens und Zugangsschlüssel zuverlässig schützt und deren sichere Nutzung in automatisierten Prozessen ermöglicht, beispielsweise mit Lösungen wie HashiCorp Vault.

Ergänzt wird dies durch eine konsequente Prozessautomatisierung mittels CI/CD- und GitOps-Pipelines, die sicherstellt, dass neue Funktionen, Konfigurationsänderungen und Updates schnell, reproduzierbar und fehlerfrei in die Plattform integriert werden können. Werkzeuge wie Bitbucket oder GitHub bilden dabei die Grundlage für eine sichere und effiziente Bereitstellung.

Die Identitäts- und Zugriffsverwaltung (Identity and Access Management, IAM) regelt klar, wer zu welchem Zeitpunkt auf welche Daten, Services oder Plattformkomponenten zugreifen darf. Lösungen wie Microsoft Entra ID oder Okta stellen sicher, dass Zugriffsrechte zentral verwaltet, nachvollziehbar und compliance-konform umgesetzt werden.

Abgerundet wird die Plattform durch eine umfassende Überwachung und Protokollierung. Monitoring-, Alerting- und Log-Collection-Mechanismen überwachen kontinuierlich den Zustand, die Verfügbarkeit und die Performance der Plattform und ermöglichen ein frühzeitiges Erkennen sowie schnelles Reagieren auf Störungen, beispielsweise durch den Einsatz von Lösungen wie Splunk.

Systems of Engagement: Die Abrufung und Nutzung der Daten im Lakehouse

Der Data Sharing Endpoint bildet die zentrale Zugriffsschicht der Plattform. Über diese Schnittstelle erhalten Business-Teams, Entwicklerinnen und Entwickler sowie Analyse- und BI-Tools wie Power BI, Tableau oder Looker direkten Zugriff auf kuratierte, einsatzbereite Datenprodukte.

An dieser Stelle entsteht der eigentliche Mehrwert der Datenarbeit, da Daten effizient genutzt, analysiert und in Entscheidungen oder neue Anwendungen überführt werden können.

Die Nutzer:innen der Plattform – darunter Entwickler:innen, Fachanwender:innen und interdisziplinäre Teams – greifen über den Data Sharing Endpoint auf die Daten zu, erstellen Reports und Dashboards oder entwickeln neue datengetriebene Anwendungen. Die Plattform stellt sicher, dass diese unterschiedlichen Nutzergruppen sicher, performant und bedarfsgerecht mit Daten versorgt werden.