Autor: Adam Szendrei

Was braucht es für eine Data- und Analytics-Plattform in der Cloud?

Um es gleich vorweg zu nehmen: Ja, auch eine komplexe Werkzeug-Landschaft, wie es eine Data- und Analytics-Plattform ist, lässt sich Cloud-native aufsetzen. Die beiden grossen Vorteile eines solchen Ansatzes sind:

- Die vielen verschiedenen Werkzeuge werden vom Cloud-Anbieter gemanaged. Der Aufwand für das Aufsetzen und den Betrieb der Plattform ist so viel geringer.

- Die Entwicklung ist durch standardisierte Prozesse und Schnittstellen viel besser zugänglich für unterschiedliche Nutzergruppen.

Im Detail ist das Thema sehr komplex:

- Wie wird die Plattform skaliert?

- Sind die Daten stets aktuell?

- Wie behält man den Überblick bei den Daten und hat die Kosten im Griff?

- Ist die Plattform sicher genug?

- Wie werden die Anwendungen deployed?

- Wie wird auf der Cloud ein sauberes Staging der Daten abgebildet?

Solche Fragen müssen beantwortet werden, wenn eine Data- und Analytics-Plattform aufgebaut werden will, on premises wie auch in der Cloud.

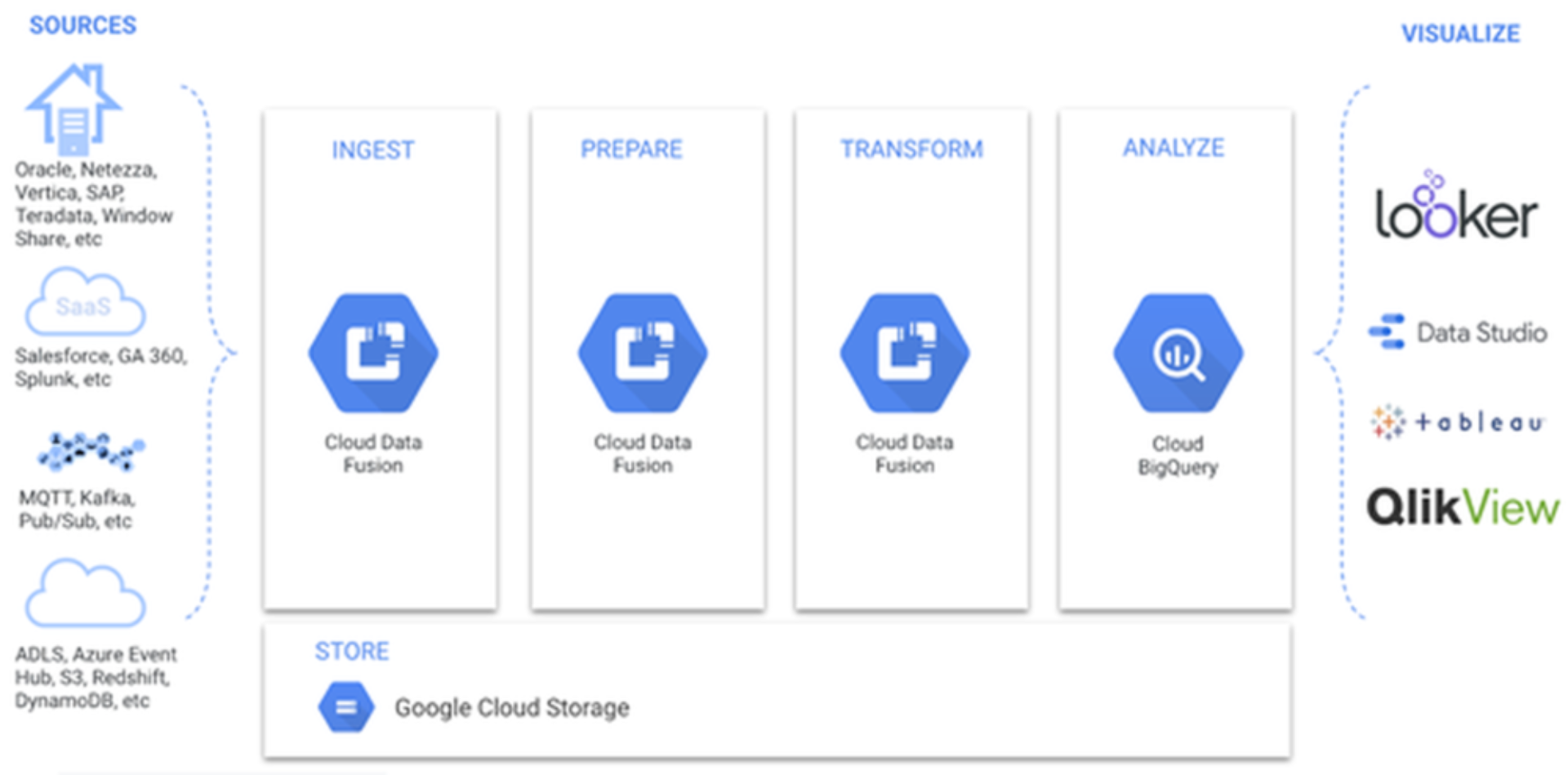

Abbildung 1 zeigt die typischen Verarbeitungsstufen eines Analytics-Projektes:

- Ingest: Integrieren verschiedener Datenquellen und -typen

- Prepare: Vorbereiten der Daten für die weiteren Prozesse (z.B. cleansing, filtering, etc.)

- Transform: Aggregieren und Kombinieren der Daten und damit neue Daten erschaffen

- Analyze: Analysieren der Daten und Erkenntnisse gewinnen

- Visualize: Visualisieren der Daten und Erkenntnisse mit einem Business-Analyse- Werkzeug

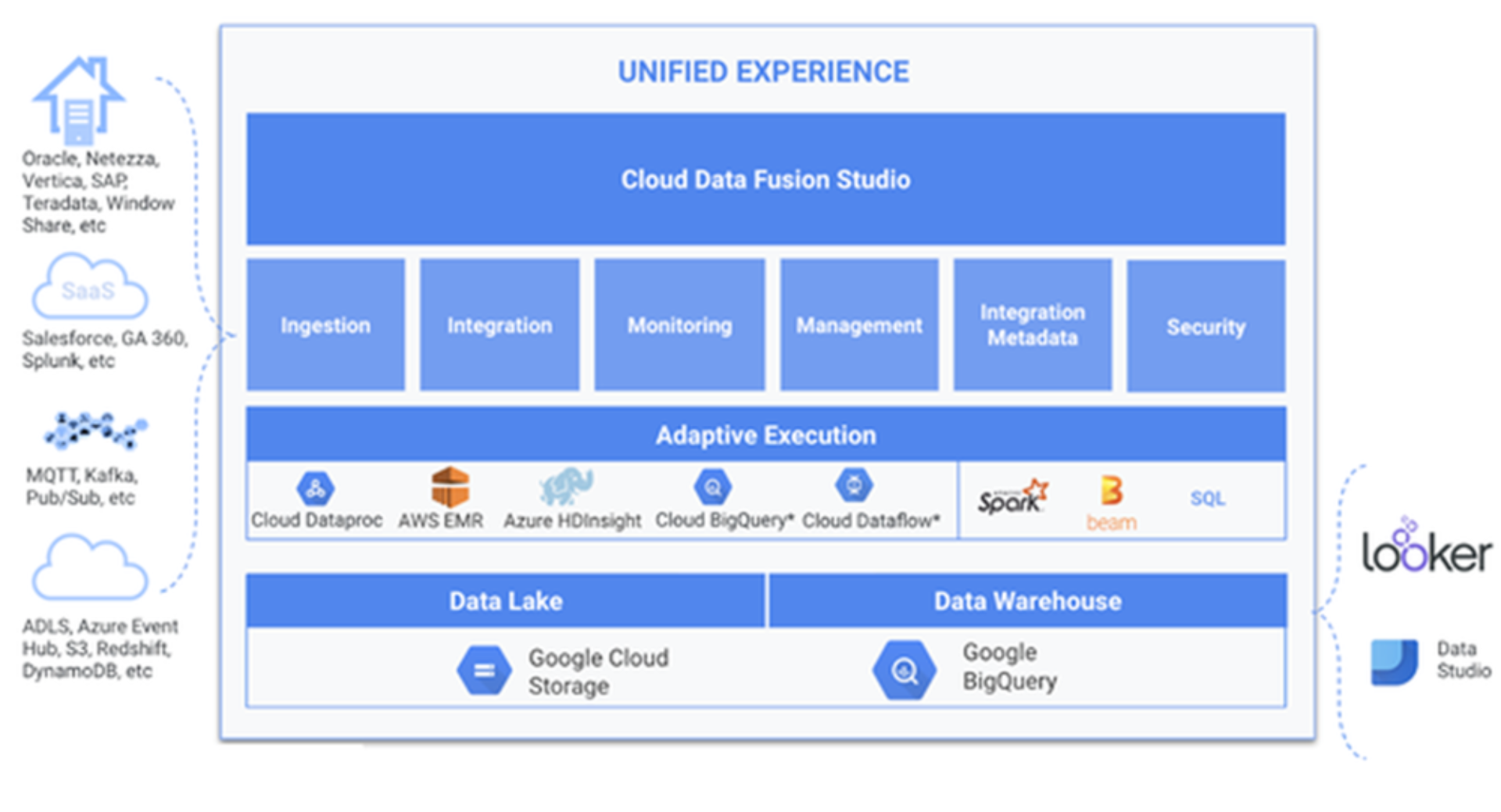

Wie erwähnt, sollte jede Data- und Analytics-Plattform diese Themen und Bereiche abdecken und die oben formulierten Fragen zufriedenstellend beantworten können. Im nächsten Abschnitt stellen wir vor, wie Google diese Herausforderung angeht.